最新文章

Vivado HLS生成高效的处理流水线

在重构内核并生成解耦处理流水线的过程中,用来在不同阶段移动数据的FIFO会形成很大开销。通过复制少量计算指令可以去除一些FIFO,这样通常很有好处,因为即使是最小深度的FIFO也会占用不少FPGA资源。

一般而言,在权衡利弊以探究最佳设计点的过程中,您可以使用成本模型和规范的优化技术。但在大多数基准测试中,仅仅为它的每个用户复制简单的循环计数器就可以节省很多面积,这也正是我们所做的。在这个引导性实例中, 该优化是指复制i的整数加法器,因此存储结果 [i]时不需要从其它模块获得索引。

内存的突发访问

第三项优化是内存的突发访问(burst-memory access)。为了更高效地利用内存带宽,我们希望通过一次内存事务处理携带多个数据字。

AXI总线协议允许您指定突发长度;而且,通过对解耦C函数进行一些小的修改,并利用流水线化的内存访问模块,我们就可利用该功能。

除了生成地址以外,解耦C函数中每个内存操作符还要在连续存储块被访问时计算突发长度。循环计数器的复制还有助于突发访问的生成,因为被访问的字数量可以在每个解耦函数中本地确定。

实验评估

我们应用上述方案做了几个案例研究。 为评估这种方法的优势,我们将使用该方案生成的解耦处理流水线 (DPP)与单纯使用HLS生成的加速器进行比较。当为单纯或DPP实现方案调用Vivado HLS时,我们将目标时钟频率设置到150MHz,并在布局布线后使用所能达到的最高时钟速率。此外,我们针对加速器和内存子系统之间的交互尝试了不同的机制。所用的端口为ACP和HP。我们为每个端口在可重配置阵列上实例化一个64KB高速缓存。

本实验所用的物理器件是赛灵思的Zynq®-7000 XC7Z020全可编程SoC,安装在ZedBoard评估平台上。

我们还在Zynq SoC 的ARM®处理器上运行应用的软件版本,并将其性能作为实验的基准。生成的所有加速器功能齐全,无需任何DMA机制将数据移入和移出可重配置架构。

案例研究1:

背包问题

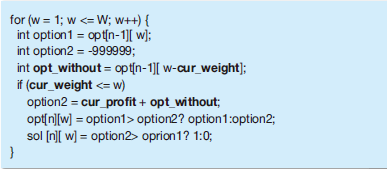

众所周知,背包问题是一个组合问题,可以通过动态编程来求解。内核的结构如图4所示。其中黑体字的变量都是在运行时间从内存读取。

图4 – 背包问题

图4代码:

for (w = 1; w <= W; w++) {

int option1 = opt[n-1][ w];

int option2 = -999999;

int opt_without = opt[n-1][ w-cur_weight];

if (cur_weight <= w)

option2 = cur_profit + opt_without;

opt[n][w] = option1> option2? option1:option2;

sol [n][ w] = option2> oprion1? 1:0;

}

因此,无法确切知道从哪个位置加载的变量opt_without。当w和n 比较大时,我们无法在片上缓冲整个opt阵列。

我们只能让计算引擎取回所需的部分。

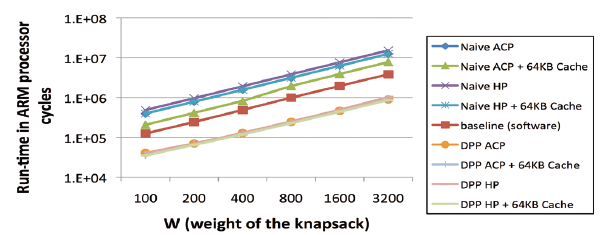

图5给出了运行时间对比情况,将使用我们的方案(DPP)生成的加速器与单纯通过HLS推送函数而生成的加速器进行比较。图中还显示了在ARM处理器上运行函数时的性能。

图5 – 针对背包问题的运行时间比较

我们将n(项数)固定为40,使w (背包的总重量)在100至3,200之间变化。

从对比中很容易看出,通过单纯使用Vivado HLS来映射软件内核这种方法得到的加速器性能比基准要求慢很多。

Zynq SoC 上的超标量无序式ARM内核能很大程度开拓指令级并行性,而且具有一个高性能片上高速缓存。Vivado HLS工具提取的附加并行性显然不足以补偿硬处理器内核对于可编程逻辑的时钟频率优势以及来自可重配置阵列的更长的数据访问时延。

不过,当内核被解耦,分成多个处理阶段时,性能就会明显比ARM处理器性能高出约4.5倍。另外,当使用DPP时,各种内存访问机制之间的差别相当小——使用我们的方案时,受内存访问时延的影响要小很多。

案例研究2:稀疏矩阵向量乘法

稀疏矩阵向量(SpMV)乘法是一个计算内核,已经在各种研究项目中以很多不同方法进行过研究、变换和基准确定。这里,我们的目的不是使用特殊数据结构和存储分配方式构建最佳性能的SpMV乘法,而是想根据最基本的算法描述看看在使用Vivado HLS时重构传递能提供多少优势。

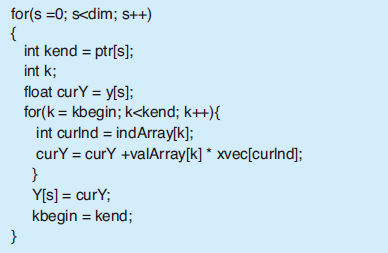

如图6所示,在我们的实验中,稀疏矩阵以压缩稀疏行(CSR)格式存储。在取回数字以进行实际的浮点乘法之前,需要先执行来自索引数组的负载。用来决定访问哪个控制流程和内存位置的数值只有在运行时间才知道。

图6 – 稀疏矩阵向量乘法

图6代码:

for(s =0; s<dim; s++)

{

int kend = ptr[s];

int k;

float curY = y[s];

for(k = kbegin; k<kend; k++){

int curlnd = indArray[k];

curY = curY +valArray[k] * xvec[curlnd];

}

Y[s] = curY;

kbegin = kend;

}

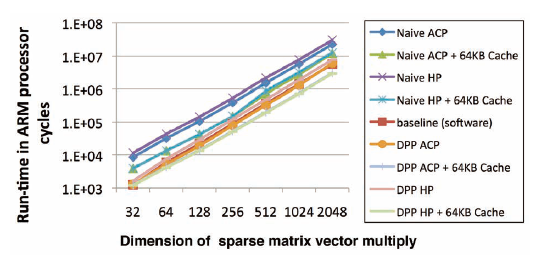

在图7所示的运行时间对比中,矩阵的平均密度为1/16,尺寸在32和2,048之间变化。

图7 – 针对稀疏矩阵向量乘法的运行时间对比

此处,单纯的映射法在性能上再次落后于软件版。当不使用FPGA上的高速缓存时,用我们的方法生成的解耦处理流水线在性能上几乎与基准性能相同。

当在可重配置阵列上实例化一个64KB高速缓存时,DPP的性能接近基准的两倍。与之前的基准相比,高速缓存的增加对DPP的性能具有更显著的影响。

案例研究3:FLOYD-WARSHALL 算法

Floyd-Warshall是一种图形算法,用来找到任意一对顶点之间成对的最短路径。内存访问模式比之前的基准要简单。因此,有可能存在一种方法可以设计出DMA+加速器结构,以获得很好的计算重叠和片外通信。我们的方案能试着自动实现这种重叠,但是我们尚未进行相关的研究,以表明绝对最佳与实际所得之间的差距。

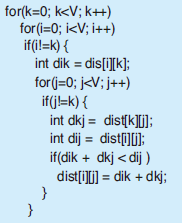

图8 –Floyd-Warshall算法

图8代码:

for(k=0; k<V; k++)

for(i=0; i<V; i++)

if(i!=k) {

int dik = dis[i][k];

for(j=0; j<V; j++)

if(j!=k) {

int dkj = dist[k][j];

int dij = dist[i][j];

if(dik + dkj < dij )

dist[i][j] = dik + dkj;

}

}

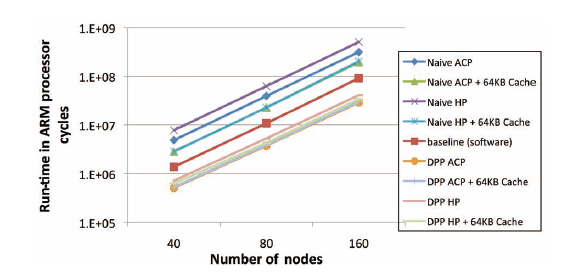

不过,与之前的基准一样,我也进行了运行时间对比。这里,我们使图形的大小在40个节点至160个节点之间变化。每个节点平均有全部节点的1/3作为其邻点。

得到的结果与背包问题中的十分类似。

图9 – 针对Floyd-Warshall算法的运行时间比较

解耦处理流水线所实现的性能约为软件基准的3倍,吞吐量达到任何单纯映射法的两倍多。当使用DPP时,对FPGA高速缓存的影响也很小,展示出了对于内存访问时延的容限。

我们这种简单的技术构建出的处理流水线可以更好地使用内存带宽,而且对内存时延有更好的容限,因此能够改善Vivado HLS的性能。所描述的方法可对控制数据流图中的内存访问和较长的依赖循环解耦,这样高速缓存缺失就不会拖延加速器的其它部分。